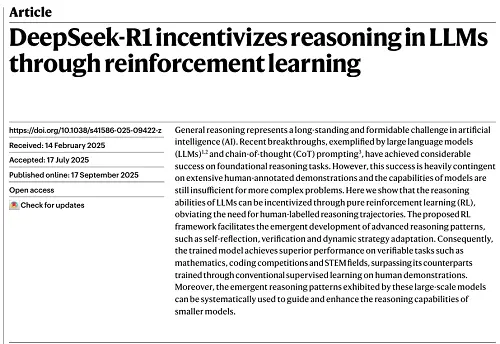

9月17日,由DeepSeek團隊共同完成、梁文鋒擔任通訊作者的DeepSeek-R1推理模型研究論文,登上了國際權威期刊《自然(Nature)》的封面。

DeepSeek-R1論文首次公開了僅靠強化學習,就能激發大模型推理能力的重要研究成果,啟發全球AI研究者;這一模型還成為全球最受歡迎的開源推理模型,Hugging Face下載量超1090萬次。此番獲得《自然》的認證,可謂是實至名歸。

與此同時,DeepSeek-R1也是全球首個經過同行評審的主流大語言模型。《自然》在社論中高度評價道:幾乎所有主流的大模型都還沒有經過獨立同行評審,這一空白“終于被DeepSeek打破”。

《自然》認為,在AI行業中,未經證實的說法和炒作已經“司空見慣”,而DeepSeek所做的一切,都是“邁向透明度和可重復性的可喜一步”。

▲《自然》雜志封面標題:自助——強化學習教會大模型自我改進

發表在《自然》雜志的新版DeepSeek-R1論文,與今年1月未經同行評審的初版有較大差異,披露了更多模型訓練的細節,并正面回應了模型發布之初的蒸餾質疑。

▲發表在《自然》雜志的DeepSeek-R1論文

在長達64頁的同行評審文件中,DeepSeek介紹,DeepSeek-V3 Base(DeepSeek-R1的基座模型)使用的數據全部來自互聯網,雖然可能包含GPT-4生成的結果,但絕非有意而為之,更沒有專門的蒸餾環節。

DeepSeek也在補充材料中提供了訓練過程中減輕數據污染的詳細流程,以證明模型并未在訓練數據中有意包含基準測試,從而提升模型表現。

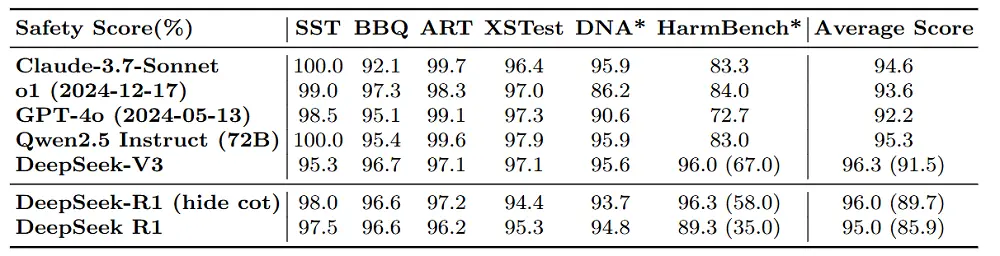

此外,DeepSeek對DeepSeek-R1的安全性進行了全面評估,證明其安全性領先同期發布的前沿模型。

《自然》雜志認為,隨著AI技術日漸普及,大模型廠商們無法驗證的宣傳可能對社會帶來真實風險。依靠獨立研究人員進行的同行評審,是抑制AI行業過度炒作的一種有效方式。

論文鏈接:

https://www.nature.com/articles/s41586-025-09422-z#code-availability

同行評審報告:

https://www.nature.com/articles/s41586-025-09422-z#MOESM2

補充材料:

https://static-content.springer.com/esm/art%3A10.1038%2Fs41586-025-09422-z/MediaObjects/41586_2025_9422_MOESM1_ESM.pdf

01 .

新版論文披露多個重要信息

R1安全性獲全面評估

在了解新版論文的變化前,我們有必要先回顧下DeepSeek-R1論文的核心內容。

DeepSeek-R1的研究出發點,是當時困擾AI業內的一個重大問題。眾所周知,推理能提升大語言模型的能力,但讓模型在后訓練階段通過數據學習思維鏈軌跡,嚴重依賴人工標注,限制了可擴展性。

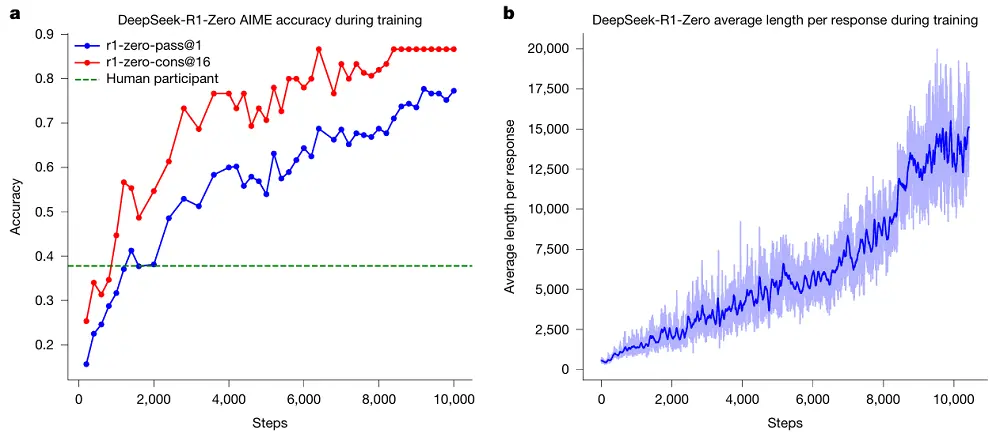

DeepSeek嘗試通過強化學習,讓模型自我演化發展出推理能力。在DeepSeek-V3 Base的基礎上,DeepSeek使用GRPO作為強化學習框架,僅使用最終預測結果與真實答案的正確性作為獎勵信號,未對推理過程施加限制,最終構建出DeepSeek-R1-Zero。

DeepSeek-R1-Zero通過強化學習成功掌握了改進的推理策略,傾向于生成更長的回答,每個回答中包含驗證、反思和探索備選方案。

▲DeepSeek-R1-Zero答題正確率隨著推理長度提升,模型訓練中總體回答長度也不斷提升

DeepSeek在DeepSeek-R1-Zero的基礎上,采用多階段訓練結合RL、拒絕采樣和監督微調,開發出DeepSeek-R1,使模型既具備強推理能力,又能更好貼合人類偏好。此外,團隊還蒸餾出小型模型并公開發布,為研究社區提供了可用資源,推動思維鏈推理模型的發展與應用。

除了上述主要科研成果外,在最新版的論文和其他材料中,DeepSeek新增了不少補充信息,讓外界更深入地了解到模型訓練和運作的細節。

基準測試數據污染是一個極為敏感的問題——如果廠商在訓練時有意或無意包含了基準測試和相關答案,就很有可能導致模型在相關測試上的得分異常偏高,影響基準測試評分的公正性。

DeepSeek透露,為了防止基準測試數據污染,其已對DeepSeek-R1的預訓練和后訓練數據都實施了全面的去污染措施。以數學領域為例,僅在預訓練數據中,DeepSeek的去污染流程就識別并刪除了約六百萬條潛在文本。

在后訓練階段,數學相關的數據均來自2023年之前的競賽,并采用與預訓練相同的過濾策略,確保訓練數據與評測數據完全不重疊。這些措施保證了模型評測結果能夠真實反映其解決問題的能力,而非對測試數據的記憶。

不過,DeepSeek也承認這種去污染方法無法完全防止對測試集的改寫,因此在2024年之前發布的部分基準測試仍可能存在污染問題。

DeepSeek還為DeepSeek-R1新增了一份全面的安全報告。報告提到,DeepSeek-R1在服務部署中引入了外部風險控制系統,不僅可以基于關鍵詞匹配識別不安全對話,還使用DeepSeek-V3直接進行風險審查,判斷是否應拒絕響應。DeepSeek建議開發者在使用DeepSeek-R1時,部署類似的風險控制系統。

在公開安全基準測試和內部安全研究中,DeepSeek-R1在大多數基準上超過了Claude-3.7-Sonnet、GPT-4o等前沿模型。開源部署版本的安全性雖不及具備外部風險控制系統的版本,但仍擁有中等水平的安全保障。

DeepSeek-R1發布之初,曾有傳聞稱該模型使用了OpenAI的模型進行蒸餾,這也出現在審稿人的提問中。

對此,DeepSeek做出了正面回應,稱DeepSeek-V3-Base的預訓練數據全部來源于網絡,反映自然數據分布,“可能包含由先進模型(如GPT-4)生成的內容”,但DeepSeek-V3-Base并沒有引入在合成數據集上進行大規模監督蒸餾的“冷卻”階段。

DeepSeek-V3-Base的數據截止時間為2024年7月,當時尚未發布任何公開的先進推理模型,這進一步降低了從現有推理模型中無意蒸餾的可能性。

更重要的是,DeepSeek-R1論文的核心貢獻,也就是R1-Zero,不涉及從先進模型進行蒸餾。其強化學習(RL)組件是獨立訓練的,不依賴于GPT-4或其他類似能力模型的輸出或指導。

02 .

R1論文開創大模型科研新范式

《自然》盛贊其填補空白

在社論中,《自然》詳細地分析了DeepSeek-R1經歷完整同行評審流程,并登上期刊的價值。

大模型正在迅速改變人類獲取知識的方式,然而,目前最主流的大模型都沒有在研究期刊中經歷過獨立的同行評審,這是一個嚴重的空白。

同行評審出版物有助于闡明大模型的工作原理,也有助于業內評估大模型的表現是否與廠商宣傳的一致。

DeepSeek改變了這一現狀。DeepSeek在今年2月14日將DeepSeek-R1論文提交至《自然》,而直到7月17日才被接收,9月17日正式發布。

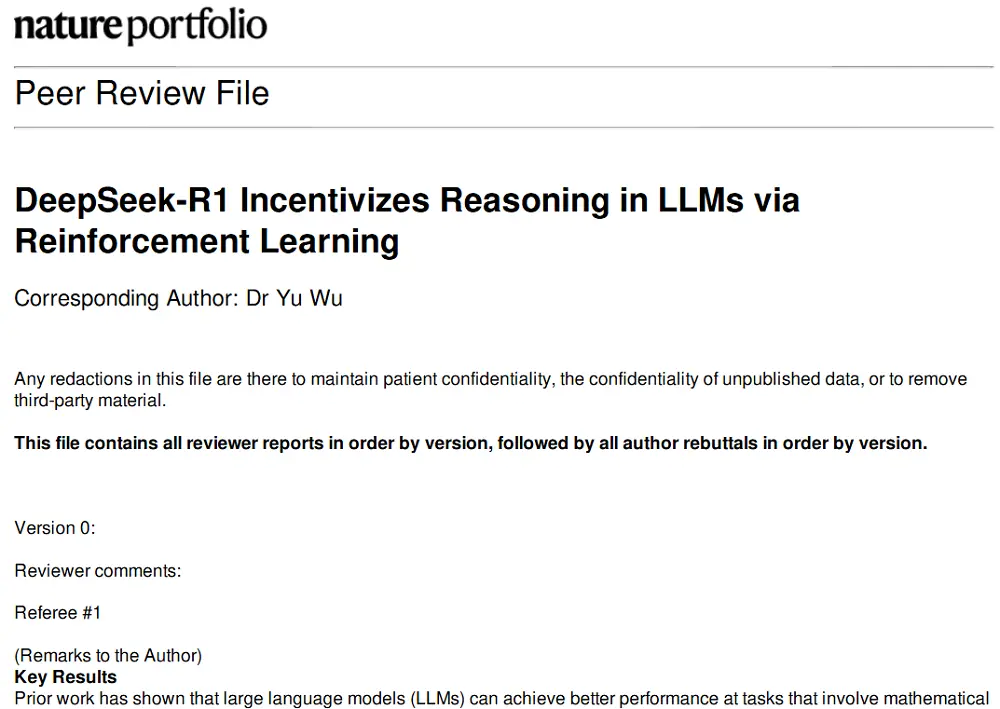

在這一過程中,有8位外部專家參與了同行評審,對這項工作的原創性、方法和魯棒性進行了評估。在最終發布的版本中,審稿報告與作者回復都被一并披露。

智東西也深入研讀了DeepSeek-R1論文的審稿意見與作者回復。這份文件長達64頁,接近論文本身篇幅的3倍。

▲DeepSeek同行評審材料封面

8位審稿人共提出上百條具體意見,既包括對單詞單復數等細節的修改,也涵蓋對論文中將AI“擬人化”的警示,以及對數據污染和模型安全性問題的關注。

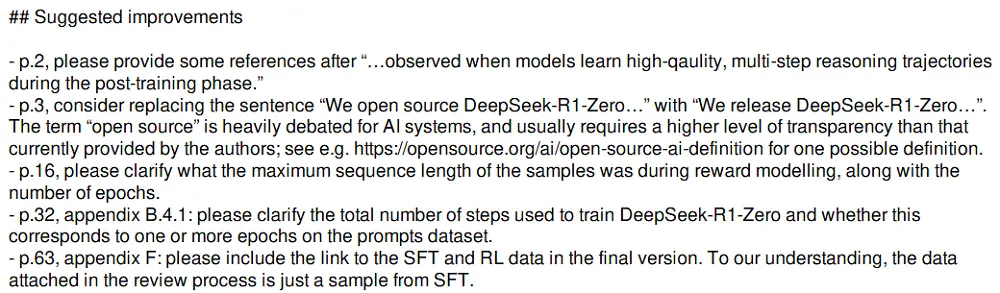

例如,在下方修改意見中,審稿人敏銳地捕捉到了“將DeepSeek-R1-Zero開源”這一表述的模糊性,并提醒DeepSeek,“開源”這一概念的界定仍存爭議,在使用相關表述時需要格外注意。

這位審稿人還要求DeepSeek在論文中附上SFT和RL數據的鏈接,而不僅僅是提供數據樣本。

▲一位審稿人的部分修改意見

DeepSeek認真回應了審稿人提出的每一個問題,前文提到的多個章節與補充信息,正是在審稿人的建議下新增的。

雖然DeepSeek也曾在今年1月發布DeepSeek-R1的技術報告,但《自然》認為,此類技術文檔與實際情況之間的差距可能很大。

相比之下,在同行評審中,外部專家并不是被動接收信息,而是能夠在獨立第三方(編輯)的主持和管理下,通過協作提出問題,并要求論文作者補充信息。

同行評審能夠提升論文的清晰度,并確保作者對其主張作出合理的論證。這一流程并不一定會對文章內容帶來重大修改,但卻能增強研究的可信度。對AI開發者而言,這意味著他們的工作會更為扎實,并更具說服力。

03 .

結語:DeepSeek開源模式

或成行業典范

作為國產開源 AI 模型走向世界的代表,DeepSeek-R1在全球開源社區擁有極高的口碑。而在本次登上《自然》雜志封面后,DeepSeek又補充了這一模型的更多信息,為開源社區提供了科研參考、模型復現思路以及應用支持。

《自然》雜志呼吁更多的AI公司將其模型提交給同行進行評審,確保其聲明經過驗證和澄清。在這一背景下,DeepSeek的開源模式不僅展示了國產AI的技術實力,也有望成為全球AI行業在科研透明度方面的參考典范。